Wyszukiwarka Google jest aktualnym liderem na rynku polskim, obejmując swoim zasięgiem blisko 92,33% wszystkich Internautów1. Na popularność i sukces wyszukiwarki ma wpływ przede wszystkim bardzo dobry system oceniania i rankingowania witryn. Mechanizm działania jest poddawany ciągłym poprawkom, które mają na celu poprawę jakości oraz prewencję przed manipulacją wynikami. Częste zmiany w algorytmie wyszukiwarki wymuszają na branży SEO ciągłe ulepszanie metod pozycjonowania.

Tylko w 2009 roku w algorytmie wprowadzono od 350-400 modyfikacji usprawniających działanie mechanizmu przeszukującego sieć. Jednym z najistotniejszych elementów wyszukiwarek jest robot (pająk), który jest oprogramowaniem specjalnie zaprojektowanym do zbierania informacji o witrynach. Robot wyszukiwarki porusza się po odnośnikach zamieszczonych na stronach www, a proces ten nazywany jest indeksowaniem (crawling).

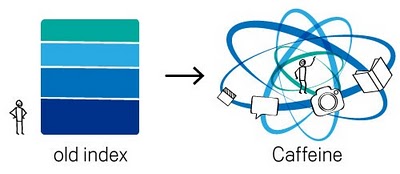

Celem pająka jest wstępna weryfikacja napotkanych dokumentów. Przeważnie proces indeksowania składa się z następujących kroków: rozpoznanie słów kluczowych występujących w dokumencie; usuwanie zbędnych-popularnych fraz; rozdzielenie i zliczenie występujących tematów; obliczanie wag dla wyszukanych słów; przypisanie dokumentowi określających go fraz z wagami. Pozyskane dane przekazywane są następnie do centralnego ośrodka (bazy danych). Ostatnia duża zmiana w procesie indeksowania wyszukiwarce Google miała miejsce 8 czerwca 2010, kiedy to wprowadzono innowacyjny projekt o nazwie Caffeine. Nowy mechanizm indeksacji nie ma bezpośredniego wpływu na pozycje w rankingu, ale znacząco wpływa na prędkość pobieranych danych do bazy indeksu. Zdaniem właścicieli Google, nowy mechanizm jest szybszy o 50%, dzięki czemu może zagwarantować aktualne wyniki wyszukiwania. Zmiany spowodowane są stale zwiększającą się liczbą treści w Internecie oraz oczekiwaniom wydawców, którzy życzą sobie, aby opublikowane informacje znajdywały się w indeksie zaraz po zamieszczeniu ich na stronie.

Stary katalog składał się z kilku warstw. Niektóre spośród nich były uaktualniane szybciej niż inne. Aby zaktualizować jedną z warstw systemu, konieczne było przeszukanie całej sieci, co powodowało znaczne opóźnienia w udostępnianiu stron w indeksie. W systemie Caffeine sieć analizowana jest z podziałem na mniejsze części, a katalog jest stale i równomiernie uaktualniany. Robot wyszukiwarki odnajdując nowe strony jest w stanie momentalnie dodać je do indeksu. Dzięki temu najaktualniejsze informacje są możliwe do odnalezienia w indeksie od razu po ich publikacji.

Do porządkowania i wartościowania zgromadzonych w bazie danych wyników, które następnie prezentowane są użytkownikom, system wyszukiwawczy wykorzystuje algorytm będący formułą matematyczną. Algorytm jest ściśle strzeżonym wzorem odpowiedzialnym za ocenę zebranych danych i stworzenie rankingu.

Jednym z najbardziej zawansowanych i rozwiniętych algorytmów Google jest PageRank stworzony przez Larrego Page’a i Sergeya Brina. Opracowali oni nowy sposób wyszukiwania informacji w globalnej sieci. Obu studentów interesowała struktura sieci WWW, w której witryny połączone są między sobą za pomocą linków tworzących klasyczną strukturę grafu. Cała sieć stanowi największy w historii szkielet, który rozwija się w zawrotnym tempie. Algorytm wyszukiwarki został opracowany na podstawie analizy Garfielda oraz innych uczonych odnośnie cytowania publikacji naukowych. Ich zdaniem doskonałą metodą oceniania prac jest analiza liczby cytatów oraz adnotacji pochodzących z innych źródeł wiedzy czy dokumentów. Publikację można uznać za bardziej interesującą i wartościową dla użytkownika im częściej jest cytowana. Założyciele Google zauważyli zależność, iż cała sieć WWW opiera się na wykorzystaniu cytatów, które umieszczane są za pomocą tekstowych lub graficznych odsyłaczy.

Poprzez zamieszczenie na swojej witrynie odnośnika do innej strony użytkownik sieci oddaje na nią głos i wskazuje pozostałym Internautom miejsce warte odwiedzenia. Mechanizm wykorzystuje połączenia (w postaci odsyłaczy) między stronami www do ustaleniach ich prawdopodobnej wagi w wyszukiwaniu. Algorytm potrafił brać pod uwagę zarówno liczbę odsyłaczy do określonej witryny, jak i liczbę odsyłaczy na każdej z odsyłających stron5. Rozwiązanie to było analogiczne do metody zliczania cytatów w publikacjach naukowych. Według tego algorytmu w rankingu na pozycjach wyższych występują te witryny, które są najpopularniejsze, czyli mają największą liczbę odsyłaczy. W ten sposób Google doskonale wykorzystuje efekt sieciowy6. Każda nowa witryna, każde nowe zapytanie do wyszukiwarki uaktualniają PageRank, tym samym polepszając prezentowane wyniki. Dzięki tak przyjętej strategii rezultaty wyszukiwarki są bardziej wiarygodne niż konkurencji opierającej swoje rankingi na słowach kluczowych czy treści witryny. Zidentyfikowanie czynników odpowiedzialnych za ranking oraz ich wpływ na wynik końcowy jest niezwykle trudne7.

Samych elementów składowych może być kilkaset, a każdy z nich może charakteryzować się innym poziomem istotności. W związku z licznymi zmianami w algorytmach organicznego wyszukiwania właściciele wyszukiwarki Google zalecają, aby posiadacze stron internetowych nie skupiali się za bardzo na pojedynczych składowych PageRank. Jeśli projekt danej strony zostanie nadmiernie powiązany tylko z pojedynczymi czynnikami odczytywanymi przez algorytm, witryna będzie musiała zostawać poddawana ciągłym poprawkom. Czasami zmiany dokonywane w algorytmie przez Google są tak znaczne, że dostrzegą je nawet ci, którzy nie spędzają zbyt dużej ilości czasu na obserwacji algorytmu. Tak się zdarzyło w przypadku, który uczestnicy dyskusji na Webmaster World nazwali „Mayday”9.

Matt Cuts z Google opisał to jako: „zmianę algorytmu Google, mającą na celu usprawnienie wyświetlania w wynikach wyszukiwania stron lepszej jakości dla zapytań z długiego ogona. To ulepszenie przeszło fazę intensywnych testów i nie zostanie już cofnięte.” Spadek odwiedzin związany z „Mayday” dotyczy witryn internetowych składających się z wielu podstron niskiej jakości, znajdujących się o kilka kliknięć od strony głównej. Zmiany uderzają przede wszystkim w sklepy internetowe, których strony produktów zawierają powieloną treść, która najczęściej kopiowana jest z witryn producentów. Takie witryny według Google nie charakteryzują się żadną wartością istotną z punktu widzenia Internautów.

Właściciele wyszukiwarki cały czas sugerują, aby projektanci oraz pozycjonerzy stron nie skupiali się na pojedynczych zmianach, ale na głównym celu, jaki Google pragnie osiągnąć, czyli dostarczyć Internautom użytecznych i przejrzystych wyników wyszukiwania. Ostatnie zmiany pokazują, że Google stawia na aktualne informacje (Caffeine) oraz ciekawe i bogate w treści witryny („Mayday”). Skupienie się na contencie oraz częstych aktualizacjach pozwoli na uniknięcie zbyt wielu nieregularności w ruchu generowanym przez wyszukiwanie organiczne.

Źródła:

P. Kobis, Marketing z Google. Jak osiągnąć wysoką pozycję? Techniki pozycjonowania a SPAM, PWN, Warszawa 2007, str. 82.

ttp://pliki.gemius.pl/Komunikaty/2010/Megapanel/Wyniki_Megapanel_PBI_Gemius_czerwiec_2010.doc, [20.09.2010]

. Schwartz, Google Makes One Change Per Day To Search Algorithm, April 2010, http://searchengineland.com/google-makes-one-change-per-day-to-search-algorithm-40508, [01.09.2010].

J. Grappone, G. Couzin, Godzina dziennie z SEO. Wejdź na szczyty wyszukiwarek, Wydawnictwo Helion, Gliwice 2010, str. 72.

D. Nojszewski, Architektura informacji w kontekście budowy przestrzeni informacyjnej sieciowych systemów informacyjnych, Maj 2008, http://www.zsi.pwr.wroc.pl/zsi/missi2004/pdf/Nojszewski%20Dariusz.pdf, [02.09.2010].

http://googlewebmastercentral.blogspot.com/2010/06/our-new-search-index-caffeine.html, [03.09.2010].

P. Kobis, Marketing z Google. Jak osiągnąć wysoką pozycję? Techniki pozycjonowania a SPAM, PWN, Warszawa 2007, str. 257.

J. Grappone, G. Couzin, Godzina dziennie z SEO. Wejdź na szczyty wyszukiwarek, Wydawnictwo Helion, Gliwice 2010, str. 72.

J. Batelle, Jak Google i konkurencja wywołali biznesową i kulturową rewolucję, PWN, Warszawa 2006, str. 55.

A. Strzelecki, Zastosowanie algorytmu PageRank w wyszukiwaniu, Katowice 2008, http://web.ae.katowice.pl/strzelecki/materialy/zastosowania_algorytmu_pagerank_w_wyszukiwaniu.pdf, [06.09.2010].

A. Shuen, Web 2.0. Przewodnik po strategiach, Wydawnictwo HELION, Gliwice 2009, str. 69.

A. Strzelecki, Jak przeszukujemy sieć? „Długi ogon wyszukiwania”, Kwiecień 2007 http://www.e-mentor.edu.pl/artykul_v2.php?numer=21&id=469, [31.08.2010].

http://www.webmasterworld.com/google/4125460.htm, [06.09.2010].

V. Fox, Google Confirms “Mayday” Update Impacts Long Tail Traffic, May 2010, http://searchengineland.com/google-confirms-mayday-update-impacts-long-tail-traffic-43054, [06.09.2010].

Autor wpisu

Maciej Kędzia

Specjalista SEO